助力协作机器人更快遍及这家企业行将重磅推出新品

查看详情+一种基于手眼视觉的并联机器人标定方法

1. 燕山大学河北省并联机器人与机电系统重点实验室,秦皇岛,0660042. 燕山大学先进锻压成...

发布时间:2023-12-26 22:24:17 来源:安博电竞

1. 燕山大学河北省并联机器人与机电系统重点实验室,秦皇岛,0660042. 燕山大学先进锻压成形技术与科学教育部重点实验室,秦皇岛,0660043. 燕山大学河北省重型机械流体动力传输与控制重点实验室,秦皇岛,066004

摘要:提出了一种基于手眼视觉的并联机器人标定方法。基于环路增量法,建立了平面2-DOF冗余驱动并联机器人运动学误差与标定模型;设计了一种标定实验靶板,利用相机采集靶板图像并对其进行分割、识别、旋转补偿的处理,获取机构末端目标位置和实际位置的像素误差值;针对机构自身结构的限制,利用边界曲线识别特征角点,提出了一种基于特征角点确定检测点旋转角度的方法,在补偿相机旋转角度的基础上,再利用简化后的相机针孔模型,将像素误差值通过转换得到机构末端执行器的真实位置误差值;最后利用标定模型和通过视觉系统获取的误差值进行运动学标定。经过4次迭代,机构误差减小为原来的1/3,验证了该方法的可行性。同时该方法具有标定过程用时短、数据量小、实验成本低等优点。

并联机构运动学标定是提高并联机构精度的经济有效的方法之一,一般包含4个步骤:运动学标定模型建立、末端机构位姿测量、机构参数识别和补偿误差。

末端机构位姿的测量分为两种:一种是利用外部测量仪器如三坐标测量仪、激光跟踪仪等来确定机构位姿;另一种是利用安装在主动或从动铰链上的内部传感器来检测运动变量。目前比较流行的方法是利用视觉测量机构末端的位姿,以相机位置可大致分为相机放置机构末端的手眼视觉和不放在机构上的固定场景视觉。固定场景视觉常用于双目或单目立体视觉当中,通过放置在机构外的视觉设备获得机构末端的三维坐标信息。ZHANG等利用图像匹配技术,让双目摄像机直接识别机构末端位置姿态。手眼视觉将摄像机安装在机器人手部末端,在机器人工作过程中随机器人一起运动。李兵等将相机安装在机构末端,通过求解相机模型的外参获得机构末端的关节旋量,进而得到末端位姿;MENDIKUTE等将Optical Measuring Machine安装在机床主轴上进行机床的自标定;PALMIERI等利用手眼视觉,在运动学误差模型的基础上提出了一种基于一阶近似方法的全局标定方法。

![]()

将双目视觉安装在机器人末端,利用立体视觉测量球形靶板以获得机器人末端位置。上述手眼视觉都是摄像机安装在机构末端轴线上,没有涉及特殊机构无法放置在末端轴线上的情况。

由于实验方法的不同,利用手眼视觉进行运动学误差标定的标定方法也有所差异。AGAND等[13]在球面2-DOF并联机构上利用视觉进行运动学标定,将球面运动空间利用公式转化到平面上,再利用相机模型外参获得末端位姿。王晨学等[14]利用双目视觉辅助定位平面,利用平面约束标定法进行标定;刘峰等[15]以四自由度跟踪平台为研究对象,通过摄像机识别自制的靶板,利用针孔模型获得相机外参数得到机构末端的位置姿态。DU 等[16]基于在线标定技术,利用手眼视觉对机构末端进行实时的轨迹误差补偿,以达到提高机构精度的目的;任思旭[17]利用PNP算法建立视觉模型,通过PNP算法获取机构末端的位置姿态;李雷远[18]利用Kinect相机获取图像的深度信息,在此基础上建立视觉模型。

图像特征的识别是视觉应用的前提,利用视觉进行标定一定要识别某个靶板或机构末端零件,图像识别应用最多的就是识别特征角点。熊浩亮[19]对比Sobel算子和Canny算子并利用Sobel算子进行图像分割识别;马瑾等[20]利用ID Maker标记块作为靶板,并应用标记块识别算法得到机构末端位置姿态;LI等[21]利用MATLAB中自带的相机标定程序识别方格特征角点,并获得靶板的位置姿态。

本文提出了一种利用简化的针孔模型与特殊靶板相结合的方案,通过环路增量法的运动学标定模型,实现了机器人的标定。

在平面2-DOF冗余驱动并联机器人各个关节处建立坐标系,x轴、y轴如图1所示,z轴垂直于该平面。由于是冗余驱动机构,其末端执行器的位置P由任意两个分支就能确定,第三个分支可以随动或施加力矩驱动,所以在建立机构的几何误差模型时只需考虑用于位置控制的两个分支。此处选择第1、3分支作为位置控制分支,利用环路增量法建立机构的误差模型。

用dai(i=1,2,…,6)表示机构的连杆参数误差,用dθi(i=1,2,…,6)表示关节转角误差,用ddi(i=1,2,…,6)表示机构连杆间偏置误差,dαi(i=1,2,…,6)表示关节轴线垂直度。由于机构为平面机构,选择加工精度高的机床能够保证关节z轴基本垂直于水平面,故在D-H参数中认为ddi、dαi都为0。

其中,i=1,2,…,7,式(4)中最后一个Δ0与Δ7取值相同,这里用Δ0代替Δ7。

已知原始误差源为:驱动关节运动参量误差dθ0、dθ5,连杆参数误差dai(i=1,2,…,6);5个未知误差为:从动关节运动量参数误差dθ1、dθ2、dθ′2、dθ3、dθ7。

式(11)有3个独立方程,式(10)有2个方程,联立可以解出5个未知量。综上,建立了平面2-DOF冗余驱动并联机器人误差模型。

P点作为输出,固连在连杆l3-2上,位于3系上,d3、δ3分别为该杆相对于自身坐标系的微分平动和微分转动,该连杆在3系中的原始误差和在基坐标系中的位姿误差关系为

其中,0δ3为连杆l3-2的微分转动,即为0;0d3为相对于基坐标系的微分平动,对应于末端执行器的位置误差。

平面2-DOF冗余驱动并联机构通过两个驱动分支就能够确定机构末端的位置,上文已得到以1、3分支作为位置控制分支的误差模型。为了辨识并标定出第二分支的误差参数,以1、2分支作为位置控制分支再建立一个误差模型,误差模型与上文同理。采用D-H参数,基于环路增量法构建平面2-DOF冗余并联机构理论误差模型。将式(13)最后一列展开并忽略z方向分量,以1、3分支和1、2分支分别作为位置控制建立误差模型,得到

其中,dX为末端执行器在检测位置时测量值与理论值之间的偏差矩阵,dXi=[dxidyi]T;Wi(i=1,2)为该检测位置的参数识别矩阵;dUi(i=1,2)为位置误差的参数识别矩阵:

对于驱动误差(关节转角误差)通过控制器保证,在标定实验中作为已知量直接给出。对于A1,A2,A3三点位置误差,在加工时予以保证。则标定模型可简化为

其中,dX′i(i=1,2)为标定模型简化后末端执行器在检测位置时测量值与理论值之间的偏差矩阵;W′i(i=1,2)为标定模型简化后测量位置的参数识别矩阵;dU′i(i=1,2)为标定模型简化后位置误差的参数识别矩阵。

式(16)即为该机构最终标定模型,需要利用最小二乘法进行求解,只要保证W′非奇异,标定就可以顺利完成。

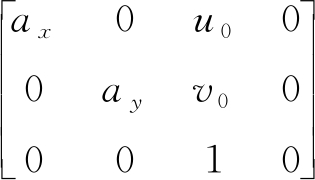

为了保证标定数据准确,减少后续位置计算的计算量,首先对摄像机内部参数进行标定,标定采用针孔模型和畸变模型,利用张正友法[24]进行标定。待标定的内部参数最重要的包含有效焦距、一阶透镜径向畸变系数和比例因子。

普通的针孔模型如图2所示。图中OcXcYcZc为相机坐标系,OdUdVd为像素坐标系,XwYwZw为世界坐标系,P′点为成像点,P点为现实中采集的点。

![]()

通过检测若干如图3所示黑色方块的四个顶点(即特征角点),将多组相邻角点的像素坐标和实际坐标代入式(18)中,求出相机的内参数以及畸变系数,结果如表1所示。

首先设计了一个用于标定实验的靶板,如图4所示。由于实验时机构末端的轨迹为一个直径160 mm的圆,所以将12个检验测试中心均匀分布在这个圆上,并且将圆心也作为一个检验测试中心。在这13个检验测试中心处作等腰三角形,等腰三角形的中心为检测中心,并且要求三角形竖直放置。

为了适应靶板的特殊样式和简化后的针孔模型,本文提出的方法要求相机不能产生相对机构末端执行器的位移和转动。由此,相机外参矩阵

![]()

其中,Δu、Δv为像素坐标系坐标差值;ΔXw、ΔYw为世界坐标系坐标插值,即真实的位置误差。

误差计算的流程如下。首先在图4所示的自制靶标上识别每一个检测点中心并记录其坐标(uk,vk)T,其中k=0,1,…,12。将机构末端原点的像素坐标系坐标(u0,v0)T与识别出的检测点的像素坐标系坐标(uk,vk)T(k=1,2,…,12)相减得到Δuk、Δvk(k=1,2,…,12),再通过式(20)将像素坐标系下的误差转化为世界坐标系下的误差ΔXwk、ΔYwk(k=1,2,…,12),即能够获得视觉标定的线 视觉标定的图像分割及识别算法

on maximum interclass variance从图5中能够准确的看出,由于实验时相机视野里会出现不止一个测量点,所以要确定当前状态下要测量的一个测量点。本文利用HSV颜色空间的H通道来识别测量点颜色,用于识别当前需要测量的测量点:

由于机构的参数和相机最小物距的限制,导致相机垂直放置时相机中心无法放置在机构末端,此方法将相机偏置放置,但相机会随机构移动而产生旋转。虽然通过机构运动学可以求解此旋转,但机构的旋转有误差,不能直接用运动学求解旋转角。为解决此问题,本文提出一种方法,可以直接识别相机的旋转角度,避开机构精度不高的缺陷。利用识别出的旋转角度可以对图像进行逆旋转,消除相机的旋转对采集图像的影响。再通过2.2节中的误差计算方式得到机构末端的真实误差。

本文采用一种基于边界曲线识别特征角点的方法,通过确定角点的位置判断旋转角度。

y)表示。由于检测点边缘是封闭的,所以极坐标(θ,ρ)能代替笛卡儿坐标表示。设检测点的中心为坐标原点,记为(x0,y0),建立极坐标系。在极坐标系下形状边缘表示为如下曲线)本文将笛卡儿坐标系下的形状边缘转化为极坐标系下的一组曲线,并利用该曲线找到角点。具体来说,在极坐标系下,圆形的边缘曲线为直线,等腰三角形的边缘曲线存在两个峰值较小的波峰和一个峰值较大的波峰。当等腰三角形发生旋转时,其边缘曲线将平移一定的距离,如图6所示。图像中最高点的x

单目视觉标定实验流程如图7所示。平面2-DOF冗余驱动并联机器人末端轨迹为先从圆心沿x轴移动80 mm,再绕直径为160 mm的圆形画圆,随后再沿

Uk为修正后的结构参数。将修正后的位置反解作为机构的输入,控制样机进行运动,并用视觉系统检测末端执行器在每个检测点的位置矩阵Xjk,j为测量位置点序号(j=1,2,…,12)。(3)用实际位置和理论位置做差求出末端执行器位置误差dXjk,即(ΔX

w,ΔYw)T。得到12组数据,组成原始误差矩阵dXk。(4)给末端执行器的位置误差矩阵dXk取模得到利用该数值作为迭代停止条件。取适当的正数

TW)-1WTdXk,其中,W为参数辨识矩阵。(6)对Uk进行结构参数补偿,迭代次数加1,转至(2)继续执行程序,直到满足为止。

本文采用基于力/位混合的冗余PID控制方案与控制样机进行实验验证,对于平面2-DOF冗余驱动并联机器人来说,其中1、3两个分支采用各关节独立的PID控制,驱动输入为两个分支的理论角位置,来保证位置精度;冗余分支输入为通过基于计算力矩计算出的驱动力。图9和图10为基于力/位混合的冗余控制框图和仿真模型。利用此仿真模型,模拟出实验轨迹下各电机的驱动力矩曲线号电机输入相应的驱动力矩曲线号电机输入转角曲线,即可实现力/位混合控制。

![]()

实验采用维视MV-EM120C CCD摄像机,分辨率为1 280像素×1 024像素,像元大小为3.75 μm×3.75 μm,靶标板采用CAD软件绘制并打印。试验流程如图8所示,机构末端从中心点向

记录机构未标定前的误差值,如表3所示。经过4次标定以后,参数辨识的结果如表4所示,标定后的误差值如表5所示。

为了评价运动学标定效果,定义综合误差值(23)作为误差评价指标,根据表4、表5中有关数据,能够获得标定前后机构末端运动学位置综合误差,如图13所示。从图13中能够准确的看出,标定后并联机构的位置精度得到了明显的提高,标定前位置精度平均误差为4.58 mm,标定后位置精度平均误差为1.55 mm,误差减小为原来的1/3。

本文为了验证视觉标定方法的优越性,利用传统标定方法再次对机构进行标定,标定实验现场如图14所示。传统标定方法基于矢量法建立机构误差模型,并利用激光跟踪仪对样机进行标定。经过5次标定,标定前后结果如表6、表7所示,标定参数辨识结果如表8所示。

da10.91mmda20.88mmda30.25mmda4-1.14mmda72.56mmda8-0.62mm利用式(23),计算出传统方法的标定前后机构末端运动学位置综合误差。标定前平均值为4.52 mm,标定后平均值为1.64 mm。通过对比两种方法的标定结果能看出,本文采用的视觉标定方法在标定精度上略胜于传统方法,并且由于本文实验用的相机像素偏小,相机参数制约了机构的精度,如果换成高像素的相机则能再一次提高机构的精度。4 结论(1)本文提出了一种基于特征角点确定检测点旋转角度的方法,解决了相机发生偏心旋转的问题,使本文提出的并联机器人运动学标定方法具有一定的普适性。(2)在能够补偿相机旋转角度的基础上,简化了相机的针孔模型,减少了实验步骤及坐标计算的计算量,使标定实验过程简单、快捷。

[2] 张宪民,曾磊.考虑减速机背隙的3-RRR并联机构的运动学标定[J].华南理工大学学报(自然科学版),2016,44(7):47-54.

[8] 张姝. 基于双目视觉的并联机构末端位姿检测研究[D].镇江:江苏大学,2016.

![]()

[16] DU G L, ZHANG P. Online Robot Calibration Based on Vision Measurement[J]. Robotics and Computer-Integrated Manufacturing, 2013, 29(6):484-492.

![]()

![]()

[17] 任思旭. 基于视觉的并联机器人运动学标定及位姿跟踪方法研究[D]. 哈尔滨:哈尔滨工程大学,2017.

[18] 李雷远. 具有视觉伺服的执行机构自主定位与精准控制研究[D].北京: 北京邮电大学,2017.

[19] 熊浩亮. 基于视觉的三轴SCARA机械手运动学标定研究[D].杭州:浙江大学,2017.

[20] 马瑾,张国峰,戴树岭,等.基于相对视觉位姿的Stewart平台运动学标定[J].系统仿线.

男,1979年生,副教授。研究方向新能源汽车能量系统建模与控制、人机一体化智能系统与工业物联网。魏自红(通信作者),男,1993年生,硕士研究生。研究方向为新能源汽车电池均衡控制系统。E-mail:。中图分类号:TP241

基金项目:国家自然科学基金资助项目(51405421);河北省自然科学基金资助项目(E2015203101)

李永泉,男,1979年生,副教授。研究方向为并联机构及机器人技术。发表论文20余篇。E-mail:。

(通信作者),男,1969年生,教授、博士研究生导师。研究方向为并联机构及机器人技术、液压系统集成及控制技术。发表论文50余篇。E-mail:

-

-

揭秘涨停 联手OpenAI全球首个GPT机器人来了人形机器人板块团体狂欢

查看详情+